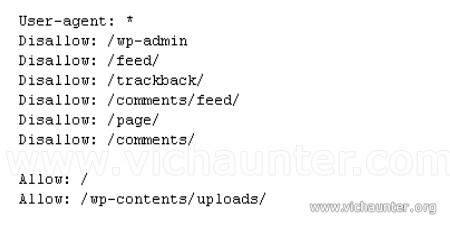

Los buscadores se dedican a recorrer todas las páginas web para así hacerse con la información que permite al usuario llegar hasta ellas con las búsquedas. Tenemos una pequeña forma de «controlar» como estos buscadores exploran nuestro sitio a través del archivo robots.txt, con el cual podemos desde decirle qué indexar hasta indicar lo que […]

Etiqueta: crawlers

![Sobrecarga de servidor por peticiones de los crawlers [Solucionado]](https://www.vichaunter.org/wp-content/themes/tecknologik/img/default.png)

En caso de que tengamos un servidor con capacidades limitadas y empecemos a tener bases de datos con muchas páginas accesibles nos podemos encontrar con un problema de sobrecarga de servidor.